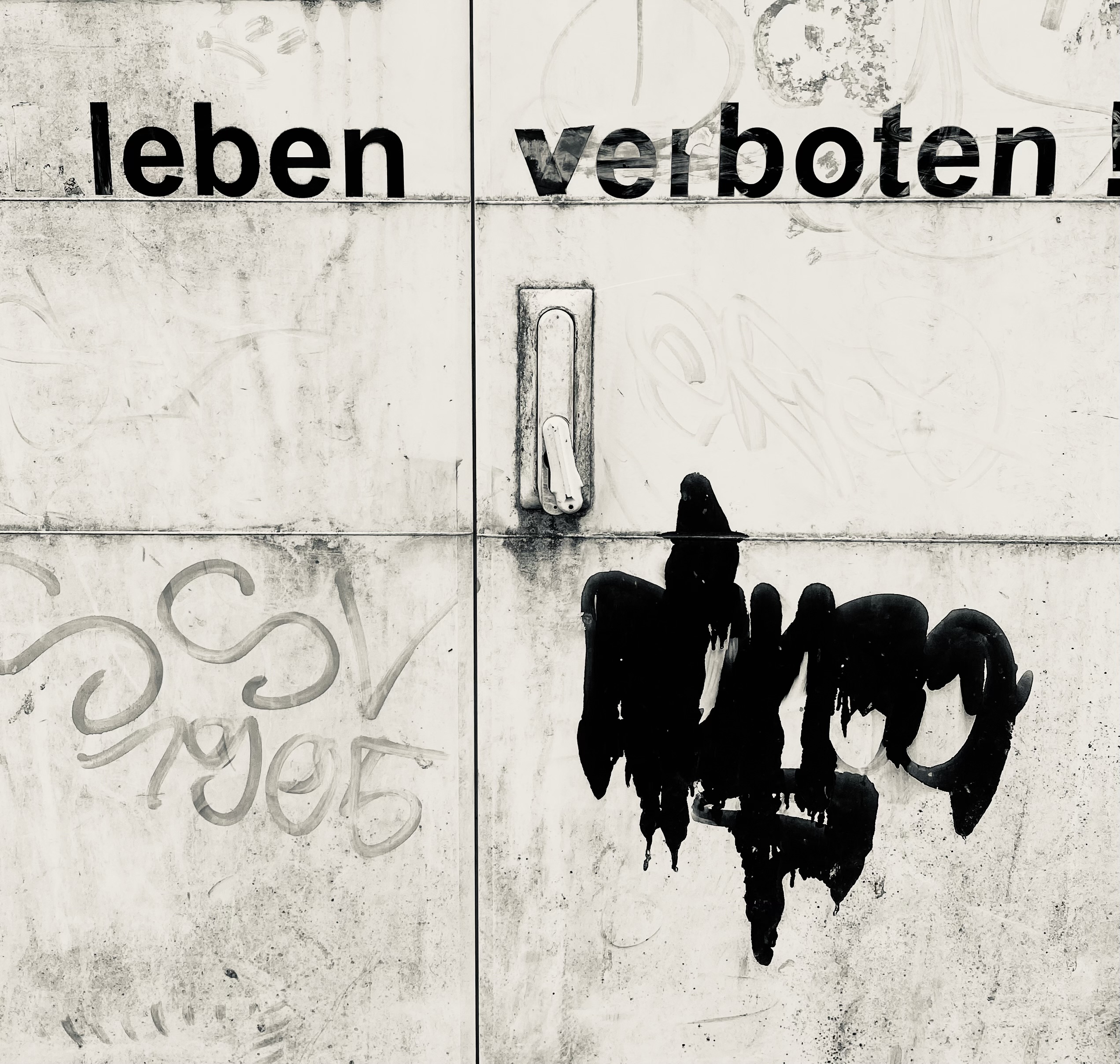

Scheinheiligkeit ist keine Erfindung unserer Zeit. Das Freudenmädchen Anna von Ulm lebte am Ende des 15. Jahrhunderts in Nördlingen. Sie arbeitete im Bordell der Stadt. Ihre Geschichte ist gut belegt. Sie stieß sich an ihren Arbeitsbedingungen und sagte vor Gericht gegen die Pächter des Freudenhauses – Barbara Taschenfeind und Leonart Freyermut – aus. Die Prozessakte erzählt viel über die Lebensbedingungen von Prostituierten in dieser Zeit. Interessant war ihre Kundenliste: Studenten, Kaufleute, Handwerker aber auch …. Priester. Unverheirateten Männern war Prostitution erlaubt. Trotzdem irritieren die Geistlichen in der Liste. Keuschheitsgelübde, Schäferstündchen und flammende Moralpredigten von der Kanzel passen nicht zusammen.

Was nun die schlüpfrige Diskrepanz von Reden und Handeln angeht, hat sich in Sachen Sexualmoral bis heute wenig verbessert. Man denke an den verbreiteten Kindesmissbrauch. Mit reuigen Worten erinnerte Papst Franziskus 2018 an die fast nicht mehr zählbaren sexuellen Übergriffe von Priestern der katholischen Kirche und bat weltweit um Verzeihung. Und ähnlich wie der Pontifex kroch unlängst auch die Partei der Grünen zu Kreuze. In einem Bericht der Aufarbeitungskommission der Berliner Grünen ist nachzulesen, welche Dimensionen Kindesmissbrauch in ihren Reihen einmal hatte. Verurteilte Pädophile bekleideten wichtige Parteiämter und der Slogan “von der einvernehmlichen Sexualität zwischen Erwachsenen und Kindern“ sollte ein moderner Gegenentwurf zu einer verstaubten Sittenlehre sein. Gemäß einer Untersuchung des Spiegels gab es wohl auch in den Reihen der FDP Herren, die mit solchen Standpunkten sympathisierten, auch wenn die Liberalen diesen Vorwurf von sich weisen. Sicher ist, dass die Berliner Liberalen nicht davor zurückschreckten, den heute umstrittenen Pädagogikprofessor Helmut Kentler als Redner einzuladen. Kentler war der Kopf eines Missbrauchsskandals, dessen Dimensionen bis heute nur ungenügend aufgearbeitet sind. Er kam auf die Idee, verwahrloste Jugendliche als Pflegekinder in die Obhut teils straffällig gewordener Pädophiler zu geben. Nach seiner Einschätzung eine Situation zum gegenseitigen Vorteil: Die Kinder, die er als “sekunddär schwachsinnig“ bezeichnete, hätten jemand, der sich um sie kümmert, während sie gleichzeitig den Päderasten als jederzeit verfügbares Objekt ihres Trieblebens dienten. Und eine Sahnekirsche gab es obendrauf: Die Sexualtäter erhielten für Kost und Logis der Opfer Pflegegeld – offiziell zugestellt von den Berliner Behörden. Helmut Kentler war zu seiner Zeit kein akademischer Wirrkopf, sondern eine honorige akademische Figur, dessen klandestine Kontakte bis hoch in den Berliner Senat reichten. Eine Untersuchung des sogenannten “Kentlerexperiments“, die von der Universität Hildesheim durchgeführt wurde, brachte Verstörendes ans Licht: der Skandal wurde von Behörden und Politikern gedeckt. Und bis zum heutigen Tag ist nicht wirklich klar, wer in den zweifelhaften Genuss eines “sekundär schwachsinnigen Pflegekinds“ kam. In den Kellern der Behörden schlummern noch viele nicht bearbeitete Akten. Die schwer traumatisierten Opfer, sofern sie noch leben, wurden bisher nicht entschädigt. Man hofft auf Verjährung.

Ohne zum Menschenfeind werden zu wollen, die Abgründe sexueller Scheinheiligkeit sind leider auch in modernen Gesellschaften eine feste Größe. Unabhängig von dieser bedrückenden Tatsache überrascht es aber, dass Doppelbödigkeit nicht nur im Bereich der Sitte eine diskursive Konstante ist. In der Politik ist sie genauso verbreitet wie im Hoheitsgebiet des wissenschaftlichen Argumentierens.

Betrachten wir in diesem Zusammenhang zuerst Hengameh Yaghoobifarah, Kolumnistin der Berliner Tageszeitung, die in einem ihrer Artikel darüber nachdenkt, was man mit den 250 000 Polizisten machen sollte, falls die Polizei abgeschafft würde. Bekanntlich plädierte sie dafür, Polizistinnen und Polizisten auf der Müllhalde zu entsorgen. Dort wären sie nur von Abfall umgeben. Das wäre perfekt, da sie sich unter ihresgleichen am wohlsten fühlen würden. Diese geschmacklose Aussage führte zu extremer öffentlicher Empörung. Die Wahrheit ist: sie gehört noch zu den harmloseren. An anderer Stelle rät sie, Polizisten und Polizistinnen von Baumärkten, Tankstellen oder Kfz-Werkstätten fernzuhalten. Dort könnten sie Bomben und Brandsätze bauen. Die Botschaft dieser Zeilen ist klar: Alle Polizisten sind für Yaghoobifarah potentielle Attentäter. Doch die umstrittene Journalistin schüttet Hass und Häme nicht nur über der Polizei aus. Deutsche werden von ihr gerne als “Kartoffeln“ bezeichnet. Außerdem redet Yaghoobifarah in dem Artikel “Deutsche, schafft Euch ab!“ von der “deutschen Dreckskultur“.

Man wundert sich, dass die Autorin in der taz eine Plattform bekommt. Die ihr zugestandene Toleranz gewährt die Zeitung nämlich nicht jedem. 2017 vergriff sich der AfD-Politiker Alexander Gauland im Ton. Er hoffte die SPD-Politikerin Aydan Özuguz, die bezweifelt hatte, dass es eine deutsche Leitkultur gibt, in Anatolien “entsorgen“ zu können. Die taz kritisierte darauf die entmenschlichende Sprache Gaulands und zieht die Schlussfolgerung, dass AfD-Spitzenpolitikern die verbalen Grenzen zum Faschismus schnuppe sind. Die eine will Menschen auf dem Müll entsorgen, der andere eine Frau in Anatolien. Beides darf man als niveaulos bezeichnen. Beides sollte man auch in gleicher Weise unterbinden.

Aber die Geschichte von Hengameh Yaghoobifarah ist nicht zu Ende erzählt. Ihre Inkonsistenz von Reden und Handeln wurde überdeutlich, als, von ihr initiiert, ausgerechnet die herabgewürdigte Polizei um Personenschutz gebeten wurde. Die kleinlaut gewordene Journalistin fühlte sich dem gewaltigen Shitstorm, den sie mit ihrem Artikel ausgelöst hatte, nicht mehr gewachsen.

Nun ist eine solche Form irritierender Doppelmoral keine exklusive Eigenschaft des linken oder linksradikalen Milieus ist. Man findet sie mit der gleichen Selbstverständlichkeit am rechten Rand der Gesellschaft. Dort wird eine multikulturelle Gesellschaft gerne mit dem Argument abgelehnt, dass Ausländer Sozialleistungen erschleichen und wenn sie denn arbeiten “den Deutschen die Arbeitsplätze“ wegnehmen. Ohne Zweifel, es gibt Sozialbetrug bei Einwanderern und dieser muss genauso konsequent geahndet werden wie bei deutschen Mitbürgern, die sich auf Kosten des Staates alimentieren. Ansonsten sollte man dieses reduktionistische Weltbild aber mit einem großen Fragezeichen versehen. Es gehört zu den positiven Erkenntnissen der Corona-Pandemie, dass in einigen Schlaglichtern die Arbeitsverhältnisse in Deutschland in einem klareren Licht erschienen. So wurde deutlich, dass bei uns ohne Gastarbeiter aus Polen, Rumänien oder Bulgarien die Räder stillständen. Das gilt vor allen Dingen für Arbeiten, die wegen ihrer Härte und schlechten Bezahlung von deutschen Arbeitnehmern verschmäht werden. Wie erhellend war der Blick in die von Coronaausbrüchen betroffenen Großschlachtereien. Wie deutlich wurde der Preis, den wir für billiges Fleisch zu zahlen bereit sind. Die Bilder von Männern mit Kreissägen, die im Akkord übermannsgroße Rinderhälften in gekühlten Fabrikhallen zerlegen, wobei Blut und Knochen spritzen, haben sich eingeprägt. Und wenn die anstrengende Schicht vorbei ist, bleibt den Malochern nichts anderes übrig, als in teils vergammelten Sammelunterkünften wieder zu Kräften zu kommen.

Ein vergleichbares Bild bei den Erntehelfern. In dem Artikel „Auf dem Gurkenflieger“ beschreibt Pauline Evers in der FAZ einige Studenten, die im Spreewald arbeiten wollten. Die anstrengende Arbeit auf dem sogenannten Gurkenflieger war allerdings recht schnell beendet. Bäuchlings auf dem Maschinenungetüm zu liegen und die Setzlinge bei schlechter Bezahlung einzugraben, hielten sie nicht lange durch. Im Gegensatz zu den rumänischen Arbeiterinnen und Arbeitern.

“Landarbeit ist krass beanspruchend für die Muskeln“ stellte eine der Studentinnen fest, die gerne mal was unter freiem Himmel mit ihren Händen machen wollte. Aber der erhoffte ländliche Zauber war schnell verflogen. Die Studenten litten physisch und psychisch. Auch der raue Ton und die Hierarchie auf dem Feld gaben ihnen zu denken. So sinnierten sie erschöpft am Lagerfeuer, ob man nicht eine Gewerkschaft für rumänische Landarbeiter gründen müsste.

Blinder Hass auf die Polizei, verbunden mit der Unfähigkeit die Funktion der Exekutive für den Rechtsstaat zu begreifen. Fehlender Respekt für die immense Arbeitsleistung ausländischer Arbeiter verbunden mit der Unfähigkeit zu verstehen, dass diese ein wesentlicher Teil unseres für selbstverständlich erachteten Wohlstands ist.

Wie können Wahrnehmungsfelder so zusammenschnurren? Und wie kann man der moralisierenden Scheinheiligkeit zu Leibe rücken, deren Wesenskern es ist, stillschweigend von dem zu profitieren, was man lauthals kritisiert.

Wie es zur Verengung des Wahrnehmungsfeldes kommen könnte, lässt Yaghoobifarah in einem Gespräch anklingen, das bei Youtube aufgezeichnet ist. Während sie sich mit ihrer Gesprächspartnerin über Depressionen unterhält, gesteht sie, dass sie nur noch in ihren “Bubbles“ lebt, wenn die Schwermut an sie herankriecht. “Bubbles“ bezeichnen Filterblasen im Internet. Das sind hermetisch geschlossene Resonanzräume, in denen man die Welt aussperrt und sich nur noch mit Gleichgesinnten austauscht. Dieses Kommunikationsverhalten verengt die Perspektive und zementiert die eigenen Vorurteile. Neu ist dieses Verhalten nicht. Früher sprach man vom Stammtischgerede. Nur hat der Stammtisch jetzt eine virtuelle Dimension.

Um die mit der Scheinheiligkeit verbundene Wirklichkeitsverweigerung zu entlarven, darf man die Perspektive aber nicht verengen. Man muss sie weiten. Deshalb wäre es für Yaghoobifarah eine Überlegung wert, ob die von ihr geschmähte “Dreckskultur“ nicht auch ihr einen persönlichen Schutzraum gewährt. Eine freiheitliche Grundordnung und eine Exekutive, die für deren Einhaltung sorgt, machen nämlich das Ausleben ihrer öffentlich inszenierten Individualität erst möglich. So macht Yaghoobifarah kein Geheimnis aus ihrer nicht-binärer Geschlechtsidentität. Das ist in Deutschland weder moralisch noch rechtlich ein Problem. Doch in anderen Ländern liefe sie Gefahr, je nach sexueller Vorliebe, gehängt, gesteinigt oder zumindest ausgepeitscht zu werden. Das gilt auch für das Heimatland ihrer Eltern, die aus dem Iran stammen.

Pars pro toto sieht man sich in der Auseinandersetzung mit dieser Autorin also mit einem Paradoxon konfrontiert: Sie ruft medienwirksam zur Zerstörung des Systems auf, das sie als Publizistin in ihrer extravaganten Individualität erst möglich macht. Und schaut man genauer hin, gibt es eine weitere Doppelbödigkeit: Es ist ein nicht nur von ihr praktiziertes Geschäftsmodell, mit einer wütenden Kapitalismuskritik Kapital anzuhäufen, das in die eigene Tasche wandert. Auf dieser Klaviatur spielen auch apodiktische Zeitgeistphilosophen wie Richard David Precht oder Byung-Chul Han, die wortgewandt das Elend dieser Welt dem Kapitalismus in die Schuhe schieben, aber nicht glaubwürdig erklären, was an dessen Stelle treten sollte. Egal. Unterm Strich bleibt ein gediegen-großbürgerlicher Lebensstil, der nicht als Widerspruch zum proklamierten Denken und Handeln empfunden wird.

Egal nun ob Yagoohbifarah die Deutschen abschaffen willoder völkische Gruppen die Gastarbeiter, derart krude Aussagen brauchen einen Resonanzboden. Deshalb sind Yagoohbifarahs Artikel ohne applaudierende linke Claqueure undenkbar. Dasselbe gilt für rechte Entgleisungen. Man erinnere sich nur an Gaulands “Vogelschiss“ oder die zitierte Entsorgung von Aydan Özuguz. Auch hier darf sich der Provokateur des Beifalls der Gesinnungsgenossen sicher sein.

Es ist in diesem Zusammenhang bemerkenswert, dass sich trotz unvereinbarer politischer Standpunkte, die rhetorische Phrasologie der verfeindeten Apologeten gleicht. Egal ob man die linksradikale Internetplattform Indymedia liest oder den Ergüssen Jürgen Elsässers auf Compact folgt, wenn er eine Ode auf die Querdenker singt, die Extremisten wähnen die Menschlichkeit allein im eigenen Lager. Im Gegensatz dazu gerinnt ihnen die gestaltlose Masse der Andersdenkenden zum kalt-repressiven System, das diese heimelige Menschlichkeit bedroht und deshalb zu bekämpfen ist.

Vielleicht sind es gerade solche klischeehaft-reduzierten Geschichten, die radikale Standpunkte in unserer schwierigen Welt so verführerisch machen. Um wieviel bequemer ist es, sich in ein eingängiges Narrativ zu flüchten, das als verführerisches Schmankerl noch die Illusion der moralischen Selbsterhöhung birgt, als quälendes Unwissenund verstörende Unsicherheiten auszuhalten, die zwangsläufig auftauchen, wenn man sich über schwierige Probleme den Kopf zerbricht?

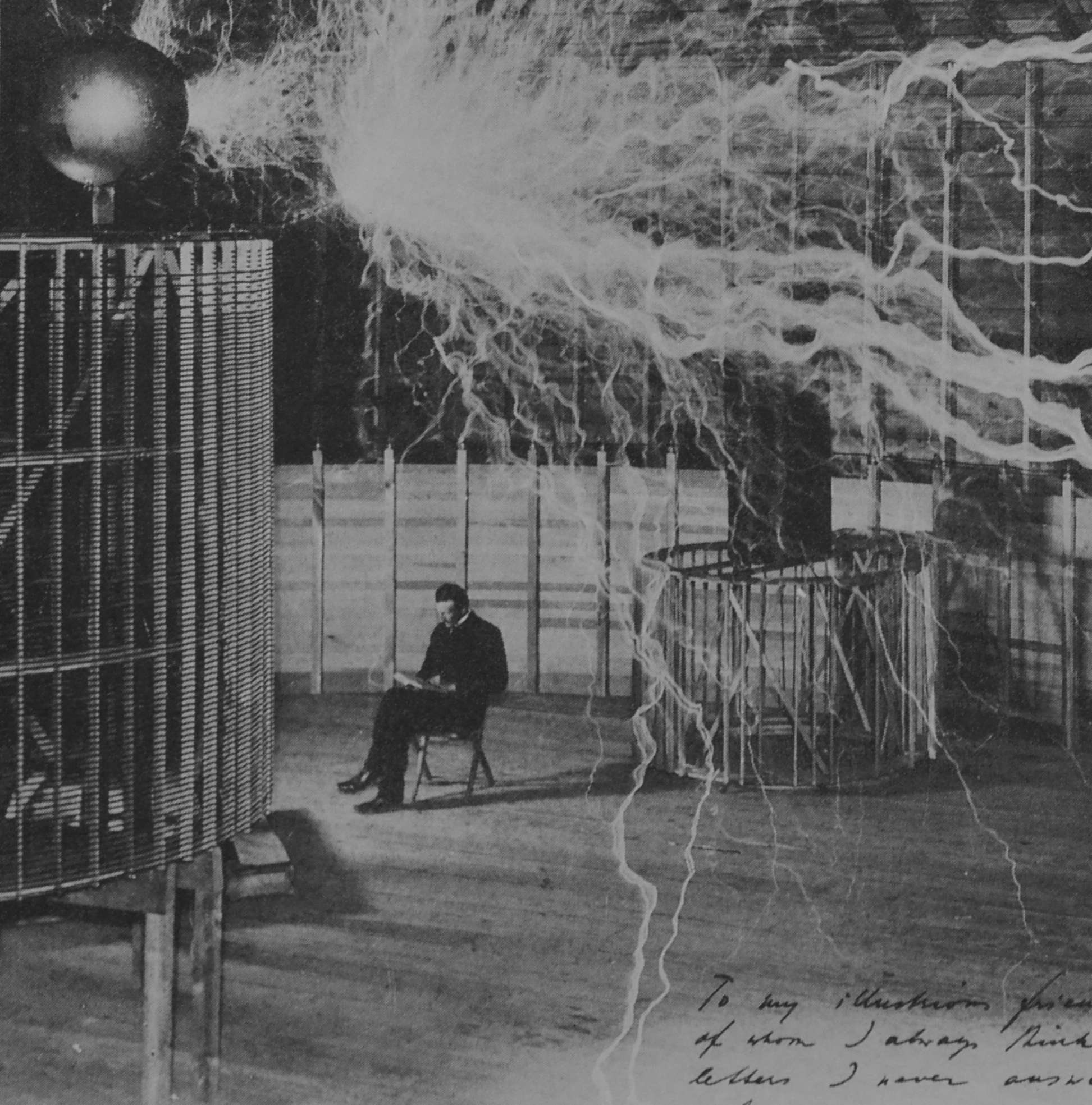

Herz schlägt Hirn. Doch trivialisierend-eingängigen Weltsichten müssen mit Vorsicht genossen werden. Sie können eine virusartige Dynamik entfalten. Das legt zumindest das Memetik-Konzept des britischen Evolutionsbiologen Richard Dawkins nahe. Meme sind in diesem Zusammenhang Gedanken, die von Menschen kommuniziert werden. Das können elegante Theorien sein aber auch irrationale Hirngespinste. Entscheidend für Ihre Verbreitung ist nicht ihre Sinnhaftigkeit sondern einzig ihr Replikationserfolg. Und gefährlich werden sie dadurch, dass spleenige Fiktionen Fakten schaffen können. Viele Querdenker verneinen die Gefährlichkeit des Corona-Virus und impfen geneigte Geister mit ihren teils abstrusen Theorien. Das aus diesen Theorien abgeleitete verantwortungslose Verhalten hilft dann dem echten Virus erst richtig auf die Sprünge.

Jetzt muss betont werden, dass opportuner Moralismus kein Alleinstellungsmerkmal radikaler Gruppierungen ist. Man findet ihn auch im gemäßigten politischen Milieu. Davon zeugt zum Beispiel die heutige Kommissionspräsidenten Ursula von der Leyen in ihrer früheren Funktion als Verteidigungsministerin. Es ist bekannt, dass sich die deutsche Bundeswehr momentan in einem maladen Zustand befindet. Bei Manövern müssen Grenadiere mit geliehenen VW-Bussen durchs Gelände heizen, da die Schützenpanzer Puma gerade nicht zur Verfügung stehen. Die Pannenflieger der Bundeswehr haben es zu trauriger Berühmtheit gebracht. Wir besitzen zwar exquisite U-Boote aber die meisten sind nicht einsatzfähig. Man unterließ es einen Wartungsvertrag abzuschließen. Vom Hick-Hack um das neue Sturmgewehr wollen wir nicht weiter reden. Die Gründe für diese Peinlichkeiten sind vielfältig. Bis vor einigen Jahren fehlte es der Bundeswehr an Geld, im Moment leidet sie wohl an einem extrem ineffizienten Beschaffungswesen.

Frau von der Leyen schickte sich an, diese ohnehin schon kritische Situation zu verschlimmern. Sie kämpfte, brav am gesellschaftlichen Commen-Sense orientiert, in der Bundeswehr für mehr “Gleichheit und Gerechtigkeit“. Es war ihr Bestreben, die Einstellungs- und Ausbildungsanforderungen soweit zu senken, dass von der Armee fast niemand mehr ausgeschlossen wird. Alle sollten mitmachen dürfen, egal ob die Bewerber übergewichtig waren oder wegen ihrer schwächlichen Konstitution keinen Rucksack tragen konnten. Von der Leyens verquere Logik war in diesem Zusammenhang nur für sie selbst schlüssig: Wenn die gefürchteten Gewaltmärsche mit schwerem Gepäck, die reale Einsatzbedingungen simulieren sollen, von vielen jungen Menschen in schlechter körperlicher Verfassung, nicht mehr bewältigt werden können, dann sorgt man nicht dafür, dass die Überforderten belastbarer werden, man schafft einfach die Märsche ab! Eine solche Logik ist gerade ja salonfähig. Wenn die Berliner Schüler als Opfer eines völlig aus den Gleisen gesprungenen Bildungssystems schlechte Noten schreiben, dann wird einfach weniger hart zensiert und schon sind die Berliner so gut wie Bayern und Sachsen. Ich mache mir die Welt, wie sie mir gefällt. Nur ist eine solche Form der Pippi Langstrumpf-Philosophie im Falle der Rekrutenausbildung kein Spiel. Die sich dem Zeitgeist anbiedernde Einstellung kann für Soldaten im wirklichen Einsatz tödliche Konsequenzen haben. Wie sieht es mit dem Segen der Gleichmacherei aus, wenn den müden Kriegern auf der Flucht im Gebirge beim ersten Anstieg die Puste ausgeht und sie von zähen Taliban verfolgt werden, die in den Bergen groß geworden sind und schon dass Messer wetzen? Dann wird das Motto “Dabei sein ist alles“ zum lebensgefährlichen Zynismus. Bleibt zu hoffen, dass Annegret Kramp-Karrenbauer die Denkfehler ihrer Vorgängerin korrigiert.

Man ist damit zu einer ernüchternden Einsicht gezwungen: In einer medialen Selbstvermarktungsgesellschaft scheint moralisierende Wirklichkeitsverweigerung gesellschaftsfähig zu sein. Das gilt selbst im Hoheitsgebiet der Wissenschaft.

Sollen wir in der Coronakrise eine Maske tragen oder nicht? In einer aufgeheizten Diskussion zeigt sich, dass es offensichtlich schwierig ist, mit dem mathematischen Konzept der Wahrscheinlichkeit umzugehen. Die fehlerhafte Argumentationsfigur kennt man aus der Kontroverse ums Rauchen. Aus der Tatsache, dass Helmut Schmidt und Winston Churchill als Kettenraucher ein biblisches Alter erreichten, folgt nicht, dass Rauchen ungefährlich ist. Entscheidend sind nicht singuläre Schicksale. Entscheidend sind Mittelwerte über einem großen Stichprobenraum. Regelmäßiges Rauchen verkürzt das Leben bei Männern im Schnitt um 9,4 Jahre. Punkt.

Der Trugschluss beim Maskentragen funktioniert ähnlich. Kommt es zu einer Infektion, obwohl Masken getragen wurden, bedeutet das nicht, das sie unnütz sind. Es zeigt nur, dass der Schutz nicht vollkommen ist. Im Schnitt verringert das Tragen der Maske das Infektionsrisiko durchaus. Das ist augenfällig, wenn man seinen Blick nach Asien richtet. Man kann sich aber auch mit einem schlichten Gedankenexperiment helfen. Es wird argumentiert, dass die Viren auf den Aerosolen das Maskengewebe einfach passieren, weil sie so klein sind. Stellen sie sich vor, sie stehen mit einem Wäschekorb voll Tischtennisbällen in einem sonst leeren Zimmer an einer Wand und schlagen die Bälle mit einem Schläger irgendwie zur gegenüberliegenden Wand! Jetzt spannen in der Mitte des Raums vom Boden bis zur Decke eine Art Tennisnetz, dessen Maschengröße so beschaffen ist, dass die Tischtennisbälle hindurchgehen. Nun wiederholen sie das Prozedere. Preisfrage: Kommen mit gespannten Netz genauso viele Bälle an der anderen Wand an? Nein. Die Wahrscheinlichkeit ist gesunken. Genauso wie die Wahrscheinlichkeit einer Infektion sinkt, wenn man eine Maske trägt.

Nun ist der Kampf um die Maske nur ein aktuelles Beispiel, bei dem Moralisten versuchen, die Wissenschaft aus dem Feld zu schlagen. Viele andere haben eine längere Tradition. Man denke etwa an den erbitterten Widerstand gegen Tierversuche in der Grundlagenforschung, bei dem radikale Tierversuchsgegner auch vor üblen Verleumdungen nicht zurückschrecken. Das ist befremdlich. Denn auch sie profitieren mit größter Selbstverständlichkeit von den Segnungen der Medizin, die sich in großem Maße Forschungsarbeiten verdanken, die auf Tierexperimenten basieren.

Um hier den Blick zu weiten und damit die Bedeutung von tierexperimenteller Forschung zu verstehen, machen wir eine kurze Zeitreise in die Anfänge des 19. Jahrhunderts. Die damalige Lebenserwartung betrug traurige 35 Jahre. Die Zustände, die zu dieser Zeit in der Medizin herrschten, sind heute nicht mehr vorstellbar. Da es keine Narkose gab, wurde selbst die Amputation eines Beins bei vollem Bewusstsein durchgeführt. Zwei Helfer hielten den panisch-brüllenden Patienten fest, der Arzt durchschnitt mit einem großen Messer das Fleisch bis zum Knochen, um dann mit einigen Streichen der Säge das Bein vollständig zu durchtrennen. Da es kein Wunddesinfektion gab, verstarb ein großer Teil der auf diese Weise behandelten Menschen. Die Chance, einen Krankenhausaufenthalt zu überleben lag damals bei etwa zehn Prozent. Die Patienten verfaulten bei lebendigem Leibe in überfüllten Zimmern, in denen die Ratten über den Boden liefen und die Wunden von Fliegen bewimmelt waren. Viele der tödlichen Wundinfektionen kennen die meisten Menschen heute nicht einmal mehr vom Namen: Gangrän, Pyämie, Erysipel

Die Entwicklung von Anästhetika, Desinfektionsmitteln oder Garnen, mit denen sich Wunden verschließen ließen, halfen, den Horror einzudämmen. Überall spielten Tierversuche in der Erforschung dieser segensreichen Erfindungen eine wichtige Rolle. Und ganz allgemein ist ihre Bedeutung auch in der modernen Medizin evident. Würde die von Tierversuchsgegnern kolportierte Überzeugung stimmen, dass sich Erkenntnisse aus Tierversuchen nicht auf die Humanmedizin übertragen lassen, dürfte heute kein einziges modernes Lehrbuch existieren!

Diese Überzeugung ist falsch und der logische Fehler gleicht der oben angeführten Argumentationsfigur. Aus der Tatsache, dass einige Ergebnisse von Tierversuchen nicht auf den Menschen übertragbar sind, folgt nicht, dass Tiere in allen Belangen anders funktionieren als Menschen. Selbst eine banale Hefezelle hat mehr mit uns gemein als die meisten denken. Trotz dieses offenkundigen Sachverhalts wähnen sich radikale Tierversuchsgegner im Recht und schrecken nicht vor Beleidigung und der Androhung von Gewalt zurück, um ihren Standpunkten Nachdruck zu verleihen. Prominentestes Beispiel ist der weltweit renommierte Gehirnforscher Nikos Logothetis, der nachweislich als “Nazi“, “Teufel“ und “Mörder“ beschimpft wurde, wobei man ihm sogar drohte ihn mit einer Eisenstange zu erschlagen, wenn er sich vor die Haustür wagen würde. Logothetis wurde als emotionslose narzisstische Forscherpersönlichkeit gescholten, dessen abstruse Forschung für Menschen keinen Erkenntniswert besitzt und nur dazu dient, sein eigenes Ego zu pudern. Die Wahrheit sieht anders aus. Logothetis war maßgeblich bei der Entdeckung des sogenannten BOLD-Effekts beteiligt. Dieser Effekt wird heute überall auf der Welt in der funktionellen Bildgebung verwendet, um Karzinome, Herzprobleme oder Schlaganfälle zu entdecken und rechtzeitig zu behandeln. Die Zahl der Menschen, die aufgrund dieser Früherkennung bisher gerettet wurden, dürfte in die Millionen gehen. Soviel zur angeblich wertlosen Grundlagenforschung. Logothetis hat auf alle Fälle dem psychischen Druck und der Verlogenheit nicht mehr standhalten können und wird Deutschland in Kürze verlassen.

Man sieht also, was auf dem Spiel steht. Wird moralischer Druck ausgeübt, der auf der Gefühlsebene punkten will, sich aber um die komplexe Faktenlage nicht schert, stehen wichtige Teile unserer Gesellschaft zur Disposition. Wollen wir tatsächlich einen Staat, bei dem die Gewaltenteilung im Grundgesetz steht, der aber auf die Polizei verzichtet? Wollen wir ein völkisch- bierseliges Deutschland? Wollen wir eine politisch korrekte Bundeswehr, die aber ihrem Verteidigungsauftrag nicht mehr gerecht werden kann? Und wollen wir auf eine effiziente medizinische Forschung verzichten? Vermutlich nicht. Deshalb muss moralisierende Scheinheiligkeit demaskiert werden. Man darf ihr nicht nachgeben, auch wenn es bequem ist, mit dem Rudel zu heulen.

Stattdessen müssen die Konsequenzen reduzierter Weltbilder von einer höheren Warte durchdacht, gewertet und artikuliert werden, um dann die Moralprediger mit diesen in aller Deutlichkeit zu konfrontieren Und im nächsten Schritt muss die Frage erlaubt sein ob sie persönlich bereit wären, die Risiken, die sich aus ihren Anschauungen ergeben, zu tragen. In diesem Zusammenhang nur zwei Fragen: Gesetzt den Fall, Frau von der Leyen hätte die Armee während ihrer Amtszeit als Verteidigungsministerin nicht vom Feldherrenhügel betrachtet sondern wäre gezwungen gewesen, in Afghanistan mitzukämpfen. Dann hätte auch ihr eigenes Leben davon abgehangen, ob die Truppe einsatzfähig ist. Wäre sie bei ihrem weltfremden Standpunkt geblieben? Und würden radikale Tierschützer bei ihrer Sichtweise bleiben, wenn sie sich sämtlichen Segnungen der modernen Medizin konsequent enthalten müssten? Vermutlich kämen selbst Hardliner zur Einsicht, dass Handeln und Reden zwei verschiedene Dinge sind, wenn vor einem großen Eingriff bei Ihnen das Narkosegerät ausbleibt und der Chirurg das Skalpell zum Schnitt ansetzt.